TPI-LLM: エッジLLMサービスのための高性能システム

Overview

- TPI-LLMは、低リソースのエッジデバイス上での大規模言語モデル推論を効率的に実現し、ユーザープライバシーとデータセキュリティを保護します。

- ローカルデータ処理を行うことにより、クラウドサービスやデータ脆弱性への懸念に効果的に応えます。

- 印象的なパフォーマンスを発揮し、レイテンシを大幅に削減することで、開発者にとって強力な選択肢となります。

TPI-LLMの紹介

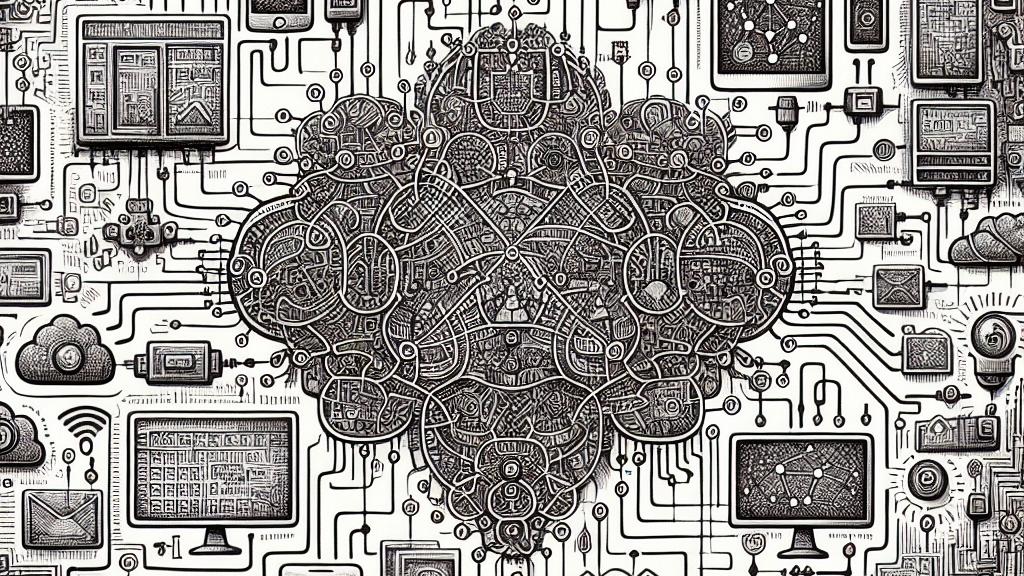

TPI-LLM、すなわち大規模言語モデルのためのテンソル並列推論は、AIとデータプライバシーに対する認識を根本的に変えつつあります。想像してみてください。機密データをクラウドに送信することなく、迅速かつ安全にリクエストに応じるインテリジェントアシスタントが身近にいる世界を。これがTPI-LLMが実現する未来です。近年、データプライバシーに対する懸念が高まる中、この技術は特に重要です。例えば、医療分野では患者のプライバシーが最優先されますが、TPI-LLMを使用することで、機密性の高い健康記録を安全にローカルデバイスで処理できます。これにより、データが危険にさらされる可能性が低くなります。また、TPI-LLMは複数のエッジデバイスを活用したテンソル並列処理を行い、標準のノートパソコンでもYi-34Bといった複雑なモデルを実行可能にします。このように、TPI-LLMは安全性とパフォーマンスの両立を実現し、AIの新たな進化を促進しています。

技術的能力

TPI-LLMの技術は本当に驚異的です。具体的には、従来のフレームワークであるAccelerateと比較して、トークンのレイテンシを80%も削減します。さらに、この数値はTransformersを含む他のフレームワークと比較しても際立っています。このような高い性能は単なる数字ではなく、例えば、TPI-LLMを搭載した顧客サービスチャットボットが瞬時に応答できる様子を想像してみてください。その結果、顧客の満足度が大幅に向上するのです。また、革新的なスライディングウィンドウメモリスケジューラーが装備されており、これによって、わずか3GBのRAMを持つデバイスでも効率よく動作することが可能です。これにより小売業や金融業界などリアルタイムの処理が必要な分野に新たな可能性をもたらします。例えば、在庫管理システムが自動で在庫状況を更新し、機密情報を守りながら運用される未来を考えてみてください。TPI-LLMは単にAIの使い方を変えるだけでなく、安全性とスピードにおいても新たな標準を打ち立てています。

未来と統合の可能性

未来を見据えると、TPI-LLMは更なる進化を遂げることが期待されています。先進的な加速技術を取り入れることで、より多様なLLMモデルをサポートし、可能性の限界を押し広げていくでしょう。たとえば、スマートシティの建設が進んだ場合、環境データを瞬時に分析し、変化に応じてリアルタイムで対応できるシステムが現実のものになります。実際に、交通信号が人々の流れに合わせて自動調整されたり、ビルのエネルギー使用が効率的に管理される場面を想像してください。加えて、TPI-LLMが進化するにつれて、オープンソースコミュニティとのコラボレーションが強化され、機能やユーザー体験が迅速に向上することが見込まれます。ローカルデータ処理を重視することで、効率を高めつつ、AIへの信頼を築くことができます。つまり、TPI-LLMは高性能なAIソリューションを提供しつつ、プライバシーを守るための新しい道を切り開くのです。結局のところ、TPI-LLMは単に技術の進歩を示すものではなく、AIの信頼性、アクセス性、反応性を向上させるための重要な一歩であると言えます。

Loading...