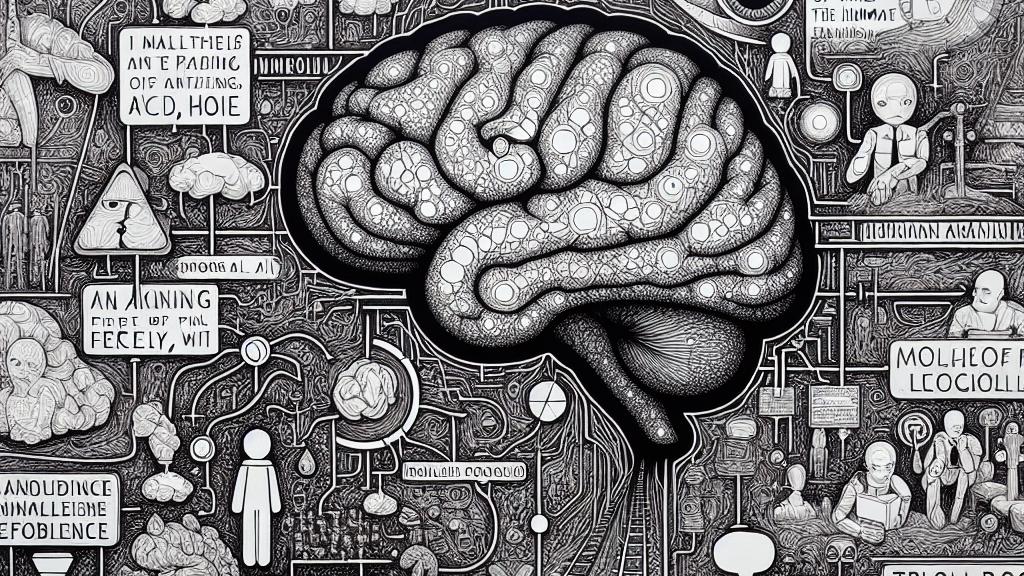

言語モデルにおける道徳的エージェンシーと自由意志の探求

Overview

- 大規模言語モデル(LLM)における道徳的エージェンシーの概念を深く探ります。

- デネットの適合主義的枠組みを利用し、従来の自由意志の概念を再構築します。

- 倫理的ジレンマにおけるLLMの意思決定プロセスの詳しい分析を行います。

LLMにおける道徳的エージェンシーの理解

この研究は、アメリカ合衆国での大規模言語モデル(LLM)が道徳的エージェンシーをどのように示すかという興味深い探求を提供しています。モーガン・S・ポーター氏は、LLMが大量のデータを解析し、倫理的な選択を行うプロセスに関与できることを強調しています。例えば、トロリー問題という、どのようにして一人を犠牲にして他の人を救うかを考える状況を見てみましょう。この場合、LLMは倫理の枠組みを使ってさまざまな結果を評価し、どの選択が最も適切かを分析します。新しい情報に基づいて決定を調整する姿勢は、人間の思考と非常に似ています。このような発見は、道徳的エージェンシーに関する従来の信念を揺るがし、意識がなくても道徳的推論を行うことができる可能性を示唆しています。

自由意志の枠組み

この研究の背後には、ダニエル・デネットやルチアーノ・フロリディのような思想家たちの深い哲学があります。彼らは自由意志を単なる絶対的なものとして捉えず、実際にはさまざまな要因によって影響を受ける複雑なスペクトルであると考えています。具体的には、自由意志は理由への応答性や価値観の整合性から形成されます。この枠組みを用いると、LLMは倫理的な環境を navigates 働く道徳的エージェントとして理解できるわけです。医療のシーンを考えてみてください。LLMが患者データをもとに治療法を提案する場合、その際、論理的な推論と道徳的要素の両方を考慮することで、機械的な意思決定がどのように人間の価値観と調和するかを示すことができるのです。このような事例は、システムを構築する際の道徳的責任についての重要な議論を生み出します。

将来の研究への影響

ポーターの発見は、倫理と人工知能の交差点での探求へと私たちを導くもので、重要な意味を持っています。私たちが新型モデルを道徳的エージェントとして再定義する過程で、AI開発における人間の責任についても考慮する必要があります。想像してみてください。将来的には、LLMが自分の選択を振り返り、社会的な価値基準に基づいて倫理的な判断を下す時代が来るかもしれません。このような進展は、私たちの機械学習に対する見方を根本から変える可能性を秘めています。また、この技術の進化は、人間と人工知能の道徳的境界を曖昧にし、AIを規制するための強力な倫理ガイドラインの必要性を一層強調します。したがって、テクノロジーが発展する中で、人工的および生物的なエージェンシーを理解することが、ますます不可欠になってきています。そのため、哲学、技術、倫理を組み合わせた学際的アプローチが必要とされるでしょう。

Loading...