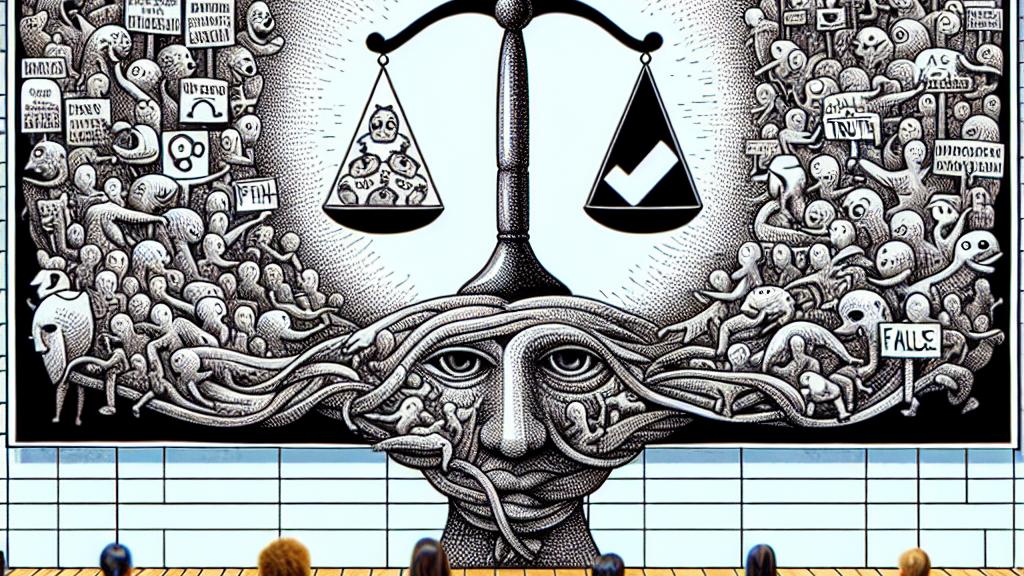

誤情報信念に対するAIファクトチェックの影響

Overview

- 驚くことに、AIファクトチェックは虚偽の見出しへの信頼を高め、重大な懸念を引き起こします。

- AIが不確実性を示すと、ユーザーは誤解を招くニュースをあっさりと共有してしまう可能性が高くなります。

- 一方で、人間が行うファクトチェックは、真実の見出しを識別する能力を大幅に改善します。

誤情報におけるAIの意図しない結果

インディアナ大学が行った最近の研究は、人工知能(AI)が誤情報と戦う上で、驚くべき真実を浮き彫りにしました。この研究はブルーミントンで行われ、AIが虚偽を特定するために開発されている一方で、実際にはその問題を深刻化させる可能性があるという逆説を示しています。具体的には、AIが確認した見出しに接した参加者は、AIが情報の信用性について不確実性を示すと、虚偽の主張を信じ込む傾向が強まることが観察されました。このような結果は実に意外で、信頼できるパートナーとしてのAIの役割に疑問を投げかけます。このため、私たちはこの技術そのものだけでなく、そこに潜む可能性のある偏見についても慎重に考える必要があります。

人間 vs AIのファクトチェック

さらに、この研究はAIによるファクトチェックと人間によるファクトチェックの間に明確な違いが存在することも明らかにしました。具体的に言うと、AIシステムは約90%の虚偽の見出しを正確に特定することができる一方で、ユーザーが真実と偽りを区別する能力の向上にはつながりませんでした。その一方で、人間のファクトチェックは一貫してこの能力を飛躍的に向上させるという効果があったのです。たとえば、GPSに頼って道を探そうとする際、時には誤った指示を受けることがありますよね。テクノロジーは確かに役立ちますが、人間のナビゲーターの存在は文脈を理解する上で非常に大きな価値があります。この現象は、テクノロジーが進化しても、人間の介入が重要であるということを再認識させてくれます。

改善されたAI戦略の必要性

将来を見据えると、多くの専門家がAI駆動のファクトチェック手法の再評価を強く訴えています。この研究から導かれる重要な教訓は、複雑な影響を考慮せずにAIツールを盲目的に受け入れることは、解決を目指す問題をさらに悪化させてしまう可能性があるということです。オンラインでの誤情報がいかに急速に広まるかを考えると、これは本当に驚くべき現象です。したがって、人間の判断と協調しながら機能するAIシステムを開発することは、選択肢ではなく緊急の課題といえるでしょう。将来的には、AIが私たちの真実の理解を深めつつ、相互の信頼を育む社会を想像してみてください。イノベーションに基づく研究が、AIによる意図しない結果を軽減する鍵となります。このデジタル時代においては、事実を確認するだけではなく、知識と責任を持った社会を育てることが私たちの使命です。

Loading...